算力困局:

AI競賽的“不可能三角”

在DeepSeek突圍之前,AI領域普遍存在一種固化的技術認知,即大模型性能與算力投入呈嚴格正相關。這一觀點幾乎成了業界的共識。美國人工智能初創公司Anthropic首席執行官達里奧·阿莫迪曾透露,GPT-4o的模型訓練成本約為1億美元。OpenAI為了訓練GPT-4,使用了數萬塊英偉達A100GPU,而微軟則為其提供了名為“星際之門(Starship)”的超級計算機集群支持。同時,谷歌也投入了其龐大的TPU(Tensor Processing Unit)資源來訓練諸如PaLM 2等模型。這些行業巨頭通過巨額的投入,不斷強化“算力即權力”的行業法則。

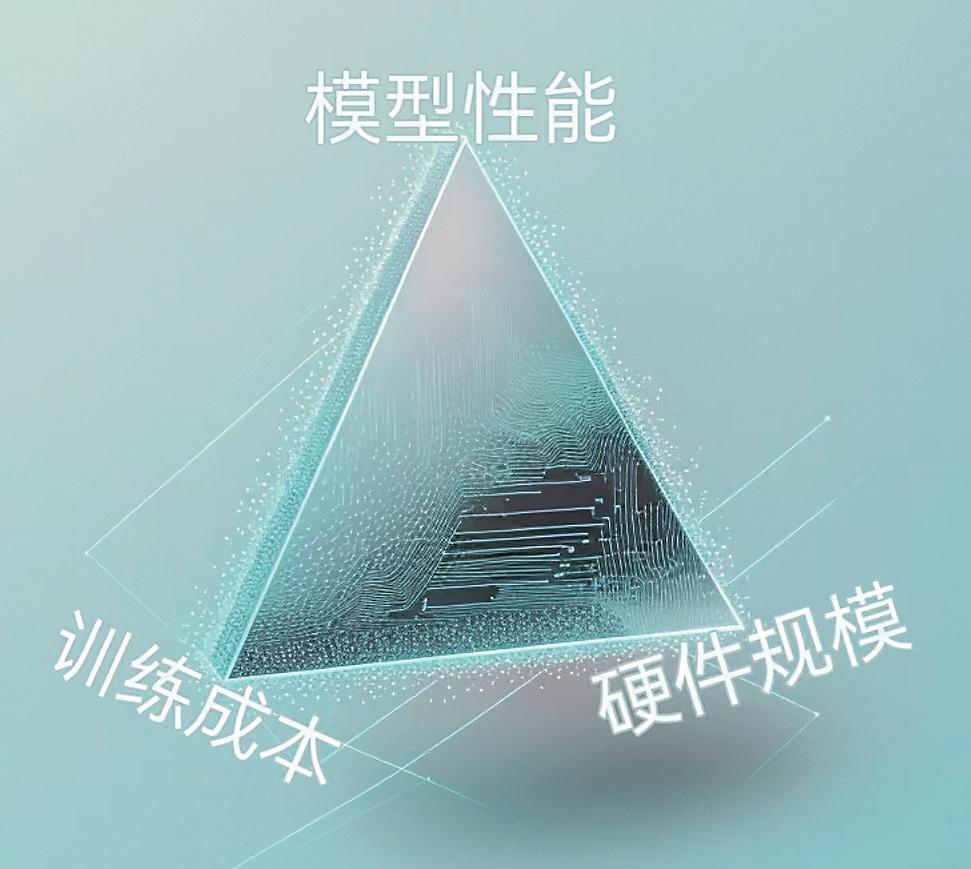

這種算力霸權形成了嚴酷的“不可能三角”困境——模型性能、訓練成本、硬件規模這三者難以兼得。面對這一困境,許多初創公司要么選擇輕量化模型犧牲性能,要么在沉重的算力開支重壓下艱難前行,最終耗盡資金。

令人欣喜的是,DeepSeek打破了這一僵局。數據顯示,Deep-Seek-V3模型訓練成本僅為557.6萬美元,而且僅用2048塊H800顯卡,耗時不到兩個月。這一成就無疑是對傳統算力霸權的一次有力挑戰。DeepSeek-V3發布后,360集團創始人周鴻祎發文稱贊“Deep-Seek的進步對推動中國AI產業發展是極大利好”,其用2000塊卡做到了萬卡集群才能做到的事。

架構革命:

DeepSeek重構AI底層邏輯

DeepSeek的技術路徑展現了對AI研發底層邏輯的顛覆性理解。其核心突破不在于單純壓縮模型規模,而是通過架構創新重構了“算力—性能”的價值函數。

在長文本方面,DeepSeek-V3引入了一種稱為多頭潛在注意力的機制。這種機制將Key(K)和Value(V)聯合映射到低維潛空間,從而有效地減小了KV Cache的大小,提高了模型處理長文本的能力。在資源調度方面,通過采用混合專家模型(MoE)架構,Deep-Seek-V3能夠根據輸入動態選擇最合適的神經網絡路徑進行計算,而不是每次都激活整個網絡。這種方法可以在不顯著增加計算成本的前提下擴展模型容量,并且只在需要時使用更多的計算資源。

為了進一步提升MoE架構的效率,DeepSeek-V3設計了一個動態調整的偏置項(Bias Term),它影響路由決策,避免了傳統負載均衡策略帶來的性能損失。它通過調節更新速度(γ)和序列級平衡損失因子(α)來優化模型訓練。

在內存優化方面,Deep-Seek-V3采用了新興的低精度訓練方法——FP8混合精度訓練。使用低精度浮點數(如FP8格式)進行計算可以減少內存占用和計算需求,同時保持較高的準確性。這意味著DeepSeek-V3能夠在相同的硬件上運行更大規模的模型或在更少的硬件上完成相同的任務。

簡單來說,模型壓縮、專家并行訓練、FP8混合精度訓練、推測性解碼等一系列創新共同促成了Deep-Seek-V3模型的低成本和高性能。

打破桎梏:

算力不應成為認知革命的絆腳石

斯坦福HAI《2024年人工智能指數報告》指出,AI模型在醫療、材料科學等領域的應用增速是基礎研究的3倍以上。站在技術演進的時間軸上回望,DeepSeek的突破在AI領域堪稱重大里程碑。此前,算力效率一直是限制AI發展的瓶頸,而如今,隨著這一桎梏被打破,創新能量開始呈指數級釋放。

DeepSeek的火爆出圈揭示了一個更深層的技術哲學:當行業沉迷于堆砌算力的“暴力美學”時,真正的突破往往來自對計算本質的重新理解。就像量子力學顛覆經典物理的認知框架,這場架構革命證明,智能的進化不完全依賴物理算力的線性增長,而在于發現更“優雅”的算法表達。

或許在不遠的未來,我們會看到更多輕量化、小而美的AI模型,在邊緣設備、在移動終端、在每個人的口袋里,持續釋放著超越物理限制的認知潛能。這場始于算力邏輯重構的技術革命,最終指向的是對人類智能邊界的重新丈量。

關鍵詞:

凡注有"環球傳媒網"或電頭為"環球傳媒網"的稿件,均為環球傳媒網獨家版權所有,未經許可不得轉載或鏡像;授權轉載必須注明來源為"環球傳媒網",并保留"環球傳媒網"的電頭。